Projekte in SenPAI

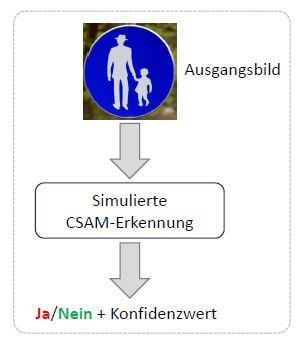

DeCNeC: Detecting CSAM Without the Need for CSAM Training Data

Die Erkennung von Missbrauchsdarstellungen (CSAM) stellt für Strafverfolgungsbehörden weltweit eine große Herausforderung dar. Während bekanntes CSAM, wie das im Rahmen einer Ermittlung beschlagnahmte Material, mithilfe von Hash-Abgleichen (z. B. wahrnehmungserhaltende Hashes wie PhotoDNA) identifiziert werden kann, erfordert die Erkennung unbekannter CSAM-Inhalte den Einsatz fortschrittlicher Methoden – insbesondere solche, die auf KI basieren. Allerdings ist bei KI der Einsatz von CSAM-Trainingsdaten aufgrund ihres hochgradig illegalen Charakters (siehe StGB §184b+c) äußerst problematisch, insbesondere für Forschungseinrichtungen.

Genau hier setzt das DeCNeC-Projekt an, das sich auf die Erkennung von unbekanntem CSAM konzentriert, ohne auf CSAM-Daten zurückzugreifen. Im Rahmen des Projekts werden neuartige Ansätze aus dem Bereich des Maschinellen Sehens (Computer Vision) erforscht und entwickelt. Die Kernidee besteht darin, separate Konzepte zu kombinieren, um dadurch eine CSAM-Erkennung zu ermöglichen. Zu diesem Zweck werden Klassifikatoren separat auf Erwachsenenpornografieszenen und auf harmlosen Bildern von Kindern in Alltagssituationen trainiert und dann fusioniert, um mögliche Schnittmengen (und damit CSAM) zu identifizieren. Darüber hinaus widmet sich DeCNeC der Erforschung von Bildverbesserungstechniken, um auch mit Bildern minderer Qualität effektiv arbeiten zu können. Parallel dazu werden Lösungsansätze entwickelt, um Herausforderungen wie der problematischen Posendarstellungen (siehe COPINE-Skala) zu bewältigen.

In enger Zusammenarbeit mit Strafverfolgungsbehörden zielt DeCNeC darauf ab, ethisch vertretbare und praxistaugliche Erkennungsmethoden zu entwickeln, mit denen die Ermittlungsarbeit präzise und effektiv unterstützt werden kann.

FROST + ML: Forensic and OSINT Technology with Machine Learning

In dem Projekt „FROST+ML“ wird untersucht, wie maschinelles Lernen (ML) die digitale Forensik unterstützen kann. Dabei werden Probleme und Herausforderungen adressiert, die in der „lokalen“ digitalen Forensik und in Open Source Intelligence (OSINT) auftreten. Das Ziel besteht darin, ein Framework zu entwickeln und zu evaluieren, das die Anwendung von ML-Technologien für Forschungsfragen in der digitalen Forensik erleichtert. Dadurch sollen neue oder verbesserte Lösungen in diesem Bereich entstehen.

LAVA: LLM-Aided and Affected Authorship Verification/Attribution

Die Entwicklung von Large Language Models (LLMs) hat die Erstellung digitaler Texte verändert und neue Herausforderungen für die Feststellung der Autorenschaft von Texten mit sich gebracht.

Das Projekt LAVA konzentriert sich auf zwei zentrale Anwendungsfälle der digitalen Textforensik: die Autorschaftsattribution (AA) und die Autorschaftsverifikation (AV). AA beschäftigt sich mit der Frage, welche Person einen gegebenen anonymen Text verfasst hat, während AV klärt, ob zwei vorliegende Texte von derselben Person stammen. Angesichts des stetig steigenden Anteils an LLM-generierten Texten wurden vier zentrale Forschungsziele identifiziert, die im Rahmen von LAVA näher untersucht werden sollen:

- Autorschaftsattribution in Bezug auf von Menschen verfasste Texte unter Verwendung von LLMs zur Extraktion stilistischer Merkmale

- Autorschaftsverifikation in Bezug auf von Menschen verfasste Texte unter Verwendung von LLMs zur Extraktion stilistischer Merkmale

- Autorschaftsattribution im Kontext von LLM-generierten versus von Menschen geschriebenen Texten, sowie die Bestimmung des eingesetzten LLMs

- Attribution von gemeinsam durch Menschen und LLMs geschriebenen bzw. generierten Texten

Das Ziel der in LAVA durchgeführten Forschung ist es, die Identifizierung und Verifikation der tatsächlichen Autorenschaft zu unterstützen, da die Grenzen zwischen menschlich und maschinell erstellten Inhalten immer mehr verschwimmen.

RoMa: Robustness in Machine Learning

RoMa zielt darauf ab, Mechanismen zur Verbesserung der Sicherheit von ML in Anwendungsprojekten bereitzustellen. RoMa wird mit anderen Technologieprojekten in Bezug auf Angriffs- und Lösungsmodelle interagieren. Ziel von RoMa ist es, die Robustheit von neuronalen Netzen und anderen ML-Algorithmen gegen bestimmte Angriffe zu erhöhen: Es geht um Angriffe, die während der Testphase Eingabedaten verändern, um entweder eine korrekte Klassifizierung zu umgehen oder eine vom Angreifer gewünschte Klassifizierung zu erzwingen.

SecLLM: Security in Large Language Models

Dieses Projekt zielt darauf ab, die Sicherheitsbedrohungen in großen Sprachmodellen (LLMs) zu analysieren und Schutzmechanismen dagegen vorzuschlagen. Derzeit sind die möglichen Schwachstellen dieser Modelle noch unbekannt. Darüber hinaus müssen selbst für die bekannten Schwachstellen noch effektive Verteidigungsstrategien gefunden werden. Unser Ziel ist es, eine taxonomische Analyse der aktuellen Angriffe durchzuführen und neue potenzielle Angriffsarten zu untersuchen. Dabei konzentrieren wir uns insbesondere auf Prompt Injection, Backdoors und Privacy Leaks. Es hat sich beispielsweise gezeigt, dass es möglich ist, das Verhalten eines LLMs zu missbrauchen, indem versteckte Eingabeaufforderungen durch Cross-Site-Scripting eingeführt und damit Phishing-Angriffe durchgeführt werden. Aufgrund der exponentiellen Verbreitung von LLMs in kommerziellen Anwendungen könnten diese Anwendungen für die Sicherheitsbedrohungen durch LLMs anfällig sein. Daher ist die Bereitstellung von Sicherheitsgarantien zur Gewährleistung von Vertrauen und Sicherheit in diesen Modellen von größter Bedeutung.

Protecting Privacy and Sensitive Information in Texts

Ziel dieses Projekts ist es, Methoden zur Verarbeitung natürlicher Sprache zu erforschen, die sensible Informationen in Texten dynamisch erkennen und verschleiern können, wobei der Schwerpunkt auf impliziten Attributen wie ethnischem Hintergrund, Einkommensbereich oder Persönlichkeitsmerkmalen liegt. Diese Methoden werden dazu beitragen, die Privatsphäre aller Personen zu schützen - sowohl der Autoren als auch anderer Personen, die im Text erwähnt werden. Darüber hinaus gehen wir über spezifische Textquellen wie soziale Medien hinaus und zielen darauf ab, robuste und hochgradig anpassungsfähige Methoden zu entwickeln, die sich über Domänen und Register hinweg verallgemeinern lassen. Unser Forschungsprogramm umfasst drei Bereiche. Erstens werden wir den theoretischen Rahmen der Differential Privacy auf unser Szenario der impliziten Textobfuskation ausweiten. Die Forschungsfragen umfassen grundlegende Datenschutzprobleme im Zusammenhang mit Textdatensätzen. Zweitens werden wir bestimmen, inwieweit unüberwachtes Pre-Training eine domänenunabhängige Privatsphäre erreicht. Drittens ist die große Lücke zwischen formalen Garantien und sinnvollen Datenschutzfähigkeiten auf eine Diskrepanz zwischen theoretischen Grenzen und bestehenden Bewertungstechniken auf der Grundlage von Angriffen auf die Systeme zurückzuführen.

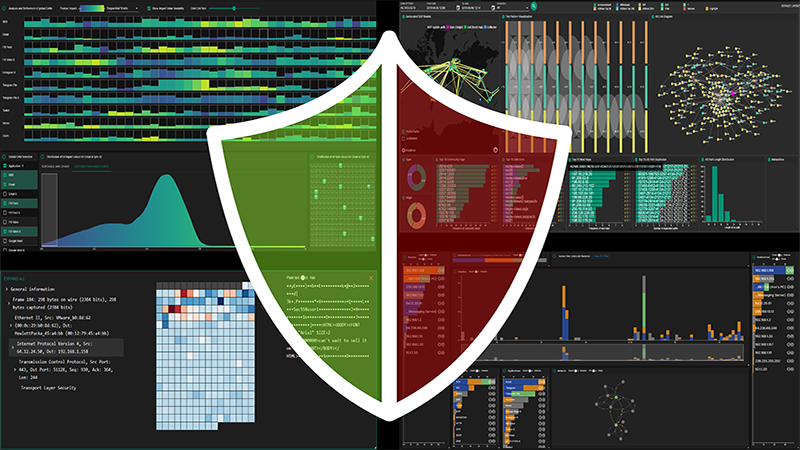

VCAXAI: Interactive Visual Cyber Analytics for Trust and Explainability in Artificial Intelligence for Sensitive Data

Dieses Projekt befasst sich mit der Integration von Machine Learning (ML) und Visual Analytics im Bereich der Cybersicherheit. Der Schwerpunkt liegt auf Explainable AI (XAI) und der Verständlichkeit gesammelter Cybersecurity-Daten, während gleichzeitig die Transparenz und Interpretierbarkeit von ML verbessert wird. Durch den Einsatz modernster KI-Techniken in Cybersicherheitsszenarien zielt das Projekt darauf ab, Cybersicherheitsanalysten dabei zu unterstützen, das Netzwerkverhalten besser zu verstehen und Bedrohungen mit größerer Präzision zu identifizieren.

Die Integration von ML und Visual Analytics (VA) spielt eine zentrale Rolle bei der Entwicklung interaktiver Werkzeuge, die Analysten nicht nur ein tieferes Verständnis der Daten ermöglichen, sondern auch die KI-gestützten Entscheidungen nachvollziehbar machen. Der Ansatz basiert auf nutzerzentriertem Design und der kontinuierlichen Einbindung von Experten in jeder Phase. Dadurch wird sichergestellt, dass die KI-Modelle zuverlässig, interpretierbar und optimal auf die realen Herausforderungen der Cybersicherheit abgestimmt sind.

VisPer: Visual Forensic Person Verification

Die Wiedererkennung von Personen wird bereits erfolgreich in verschiedenen Anwendungsbereichen eingesetzt, etwa bei biometrischen Zugangskontrollen oder der Echtzeitüberwachung öffentlicher Räume. In der forensischen Analyse stellt die Personenwiedererkennung jedoch nach wie vor eine besondere Herausforderung dar. Relevante Merkmale sind häufig nur eingeschränkt sichtbar, etwa durch Verdeckung oder geringe Bildauflösung, und unterliegen zudem zeitlichen Veränderungen, zum Beispiel durch Alterung, Frisur, Körperform oder Kleidungsstil.

Im Projekt VisPer wird untersucht, wie Personen unter diesen und weiteren erschwerten Bedingungen mithilfe moderner Computer-Vision-Methoden wiedererkannt werden können. Eine zentrale Rolle spielen dabei sogenannte weiche biometrische Merkmale wie Tattoos oder Narben, die über lange Zeiträume hinweg stabil bleiben. Um Forensikerinnen und Forensiker effektiv bei der Fallbearbeitung zu unterstützen, muss die Personenwiedererkennung flexibel an unterschiedliche forensische Fragestellungen anpassbar sein und nachvollziehbare, interpretierbare Entscheidungen liefern.

Aus diesem Grund wird das im Projekt VisPer entwickelte System gezielt für die Zusammenarbeit mit forensischen Expertinnen und Experten konzipiert. Kriterien für den Personenabgleich können fallabhängig angepasst werden, während die getroffenen Entscheidungen transparent begründet und dadurch menschlich überprüfbar bleiben.

In enger Zusammenarbeit mit Strafverfolgungsbehörden entwickelt VisPer neue und effektive Methoden für Personenabgleiche in forensischen Analysen. Mögliche Anwendungsszenarien umfassen unter anderem die Identifikation vermisster Personen sowie die Wiedererkennung von Opfern oder Tatverdächtigen.

Beendete Forschungsprojekte

Adversarial Attacks on NLP systems

Laufzeit: 01.01.2020 - 31.12.2023

Das Projekt konzentrierte sich auf eine zweite Herausforderung in der ML/KI-Sicherheit, bei der KI-Systeme als Angreifer eingesetzt werden. Der Schwerpunkt lag hier (NLP) auf textuellen Daten. Das Projekt befasste sich mit Hatespeech und Desinformation, welche relevante Szenarien in OSINT-Anwendungen sind. Ergebnisse können auch im SePIA-Projekt genutzt werden, da OSINT oft auf Textdaten basiert. Wissenschaftliche Erkenntnisse aus dem Projekt sind:

Robustheit

- Neue Methode namens Confidence Regularization, die bekannte und unbekannte Verzerrungen abmildert

- Neuartiger Debiasing-Rahmen, der mehrere Verzerrungen auf einmal behandeln kannn

Modelleffizienz

- Neue Adapterarchitektur namens Adaptable Adapters, die eine effiziente Feinabstimmung von Sprachmodellen ermöglicht

- Neue Transformer-Architektur, die Rational Activation Functions verwendet

Datenerfassung

- Analyse der Quellen von Verzerrungen und Verbesserung der Datenerfassung durch Erforschung des Potenzials von Bürgerwissenschaftlern

Bewertung generativer Modelle (z. B. LLMs)

- Identifizierung von Fallstricken und Problemen bei der Verwendung bestehender Inferenzheuristiken für die Bewertung

- Entwicklung eines neuartigen Rahmens für die Generierung synthetischer Daten: FALSESUM

SePIA: SEcurity and Privacy In Automated OSINT

Laufzeit: 01.01.2020 - 31.12.2024

SePIA ist ein Anwendungsprojekt, das sich mit verschiedenen Herausforderungen in der automatisierten Open Source Intelligence (OSINT) befasst. Ziele sind die Verkapselung des OSINT-Prozesses in eine sichere Umgebung, nach dem Privacy-by-Design-Prinzip sowie die Anwendung fortgeschrittener Crawling- und Informationserfassungskonzepte zur Automatisierung der Suche nach verfügbaren Datenquellen. Gleichzeitig wird ML genutzt, um den aktuellen Stand der Technik des Crawlens zu verbessern. Weitere Ziele sind die Verbesserung der Datenbereinigung durch Hinzufügen einer Rückkopplungsschleife zu Crawling- und Analysemodulen sowie die Verbesserung der Analysemethoden für automatisierte Intelligenz auf Grundlage von ML.

XReLeaS: Explainable Reinforcement Learning for Secure Intelligent Systems

Laufzeit: 01.07.2019 - 31.12.2024

Dieses Projekt befasst sich mit Aspekten der Transparenz sowie mit der Nachvollziehbarkeit von Ergebnissen und Netzen in ML. Ziel ist es, eine Software-Toolbox für nachvollziehbares ML zu erstellen, die auch andere Sicherheitsaspekte der Algorithmen erhöht. Als Beispiel dient eine Roboterumgebung.